Модуль высокоскоростного сбора и воспроизведения данных

Пожалуй, самое распространенное заблуждение в нашей отрасли – это представление о модуле высокоскоростного сбора и воспроизведения данных как о чем-то готовом к использованию, 'plug and play'. На деле же, разработка и внедрение подобного решения – это целая куча нюансов, от выбора датчиков и аналого-цифровых преобразователей (АЦП) до алгоритмов сжатия и обработки данных. Особенно это ощущается, когда речь заходит о сложных, динамических системах, где требуется не просто фиксировать данные, а корректно их интерпретировать и использовать в реальном времени. Я уже неоднократно сталкивался с ситуациями, когда изначально 'хорошо выглядящее' решение оказывалось совершенно непрактичным в условиях реальной эксплуатации.

Проблемы масштабируемости и синхронизации

Начнем с простого – масштабируемости. Большинство готовых решений рассчитаны на относительно небольшое количество каналов ввода. Но что делать, если нужно собирать данные с сотен, а то и тысяч датчиков? Простое наращивание количества АЦП, как правило, не решает проблемы – возникает лавинообразный рост сложности обработки и необходимость в мощных вычислительных ресурсах. Мы в ООО Сиань Чэнань Измерение и Контроль Технологии (https://www.xacamc.ru) часто сталкиваемся с запросами на разработку кастомизированных решений именно для таких сценариев. В нашем случае, это требует глубокого понимания не только аппаратной части, но и алгоритмов распределенной обработки данных, а также сетевой инфраструктуры.

Не менее важным является вопрос синхронизации. Представьте себе систему, где данные с различных датчиков приходят с разной задержкой. Это приводит к искажению картины происходящего, особенно в приложениях, требующих точного времени отклика. Для решения этой проблемы используются различные методы – от аппаратной синхронизации до сложных алгоритмов временной компенсации. Но даже при использовании самых современных технологий, всегда остается некоторая погрешность, которую необходимо учитывать при интерпретации данных. Особенно остро эта проблема стоит в авиационной отрасли, где даже микроскопические отклонения во времени могут иметь катастрофические последствия. Компания создана в 2011 году и специализируется на подобных задачах.

Сетевые протоколы и пропускная способность

Использование стандартных сетевых протоколов, таких как Ethernet или Wi-Fi, может оказаться недостаточно эффективным для передачи больших объемов данных в режиме реального времени. Необходимо тщательно подходить к выбору протокола и оптимизировать его параметры для достижения максимальной пропускной способности и минимальной задержки. В некоторых случаях, приходится использовать специализированные протоколы, разработанные специально для сбора данных с датчиков. Это, конечно, увеличивает сложность системы, но может быть необходимо для обеспечения требуемой производительности.

Мы работали над проектом по сбору данных с экспериментального летательного аппарата. Нам потребовалось разработать собственную прошивку для датчиков и кастомный сетевой протокол, чтобы обеспечить надежную и эффективную передачу данных в режиме реального времени. Оказалось, что оптимизация сетевого протокола дала нам прирост пропускной способности в несколько раз, что критически важно для обеспечения стабильной работы системы.

Обработка данных и алгоритмы фильтрации

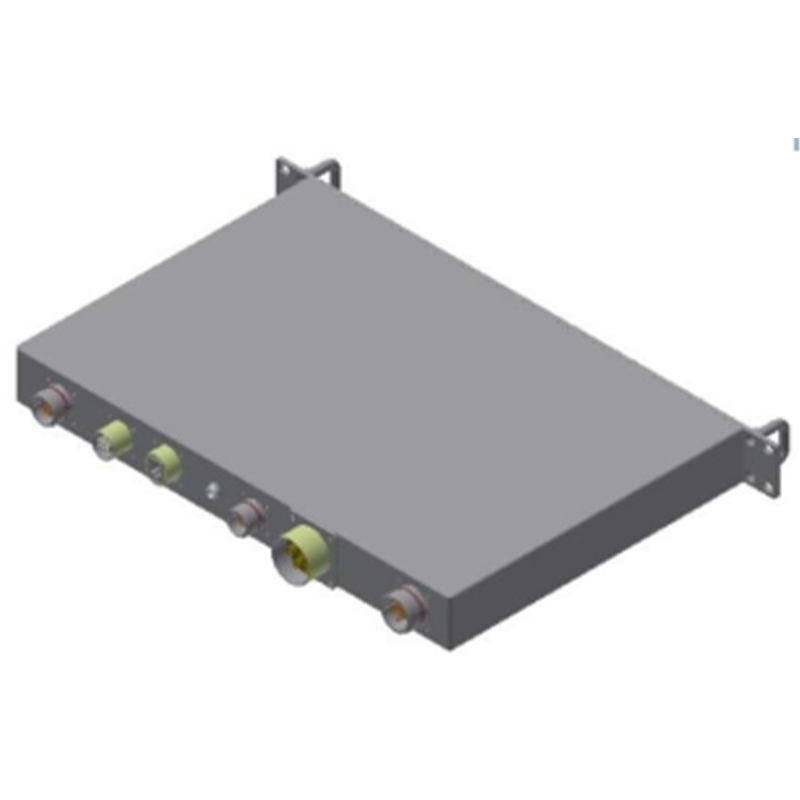

Собранные данные редко бывают 'чистыми'. Они могут содержать шум, ошибки и другие артефакты, которые необходимо удалить или компенсировать. Для этого используются различные алгоритмы фильтрации – от простых скользящих средних до сложных фильтров Калмана. Выбор алгоритма зависит от типа данных и требуемой точности. Важно понимать, что любой алгоритм фильтрации вносит определенные искажения в данные, поэтому необходимо тщательно подбирать его параметры, чтобы минимизировать эти искажения.

В одном из проектов нам потребовалось отфильтровать шум из данных, полученных с высокочувствительных датчиков температуры. Мы попробовали несколько различных алгоритмов, но только комбинация фильтра Калмана и медианного фильтра дала нам удовлетворительные результаты. При этом, мы тщательно следили за тем, чтобы фильтрация не приводила к потере важных деталей в данных.

Вычислительные ресурсы и программное обеспечение

Обработка больших объемов данных требует значительных вычислительных ресурсов. В большинстве случаев, используются многоядерные процессоры и специализированные ускорители, такие как FPGA или GPU. Также, необходимо использовать эффективное программное обеспечение для обработки данных. В качестве популярных вариантов можно назвать MATLAB, Python с библиотеками NumPy и SciPy, а также специализированные программные платформы для анализа данных.

Нам приходилось обрабатывать данные, полученные с сотни датчиков, используя кластер из 16 серверов с GPU. Мы использовали Python с библиотекой TensorFlow для обучения моделей машинного обучения, которые использовались для выявления аномалий в данных. Это позволило нам автоматически обнаруживать дефекты в работе оборудования и предотвращать аварийные ситуации.

Практические советы и рекомендации

Несколько советов, которые я могу дать тем, кто планирует разрабатывать или внедрять модуль высокоскоростного сбора и воспроизведения данных: Во-первых, тщательно проанализируйте требования к системе и определите, какие данные необходимо собирать, с какой частотой и какой точностью. Во-вторых, выберите подходящие датчики и АЦП, учитывая их характеристики и ограничения. В-третьих, разработайте эффективный алгоритм обработки данных и оптимизируйте его для достижения максимальной производительности. В-четвертых, не забывайте о синхронизации данных и используйте соответствующие методы для компенсации временных задержек. И, наконец, не бойтесь экспериментировать и пробовать новые подходы.

Важно помнить, что разработка и внедрение модуля высокоскоростного сбора и воспроизведения данных – это сложная и многогранная задача, требующая глубоких знаний и опыта. Но при правильном подходе, она может принести огромную пользу.

Вызовы, с которыми мы столкнулись

Иногда самые большие трудности возникают не с технической стороной, а с организационной. Например, когда требуется интеграция новых устройств в существующую инфраструктуру, возникают проблемы совместимости и нехватка квалифицированных специалистов. Мы сталкивались с подобным при внедрении системы мониторинга для промышленного предприятия. Изначально был выбран один поставщик оборудования, но оказалось, что его решения не полностью соответствуют требованиям заказчика. В результате пришлось искать альтернативных поставщиков и вносить существенные изменения в проект. Это заняло много времени и потребовало дополнительных ресурсов.

Еще одна распространенная проблема – это обеспечение надежности системы. В условиях реальной эксплуатации, датчики могут выйти из строя, а сеть может быть нарушена. Поэтому необходимо предусмотреть механизмы резервирования и автоматического восстановления, чтобы обеспечить непрерывную работу системы.

В заключение, хочу сказать, что разработка и внедрение модуля высокоскоростного сбора и воспроизведения данных – это интересный и перспективный, но в то же время сложный и ответственный процесс. Необходимо тщательно планировать и подходить к решению каждой задачи, чтобы достичь желаемых результатов. Мы всегда рады помочь нашим клиентам с решением подобных задач.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Оптический преобразователь с дисплейным управлением

Оптический преобразователь с дисплейным управлением -

Модуль обработки сигналов с помехозащитой

Модуль обработки сигналов с помехозащитой -

CAMPS46/56

CAMPS46/56 -

Комплексный тестер БПЛА

Комплексный тестер БПЛА -

Чаочжи SiMU9030S инерциальный измерительный модуль

Чаочжи SiMU9030S инерциальный измерительный модуль -

Комбинированный датчик температуры и давления – Тип C

Комбинированный датчик температуры и давления – Тип C -

CAMPS49

CAMPS49 -

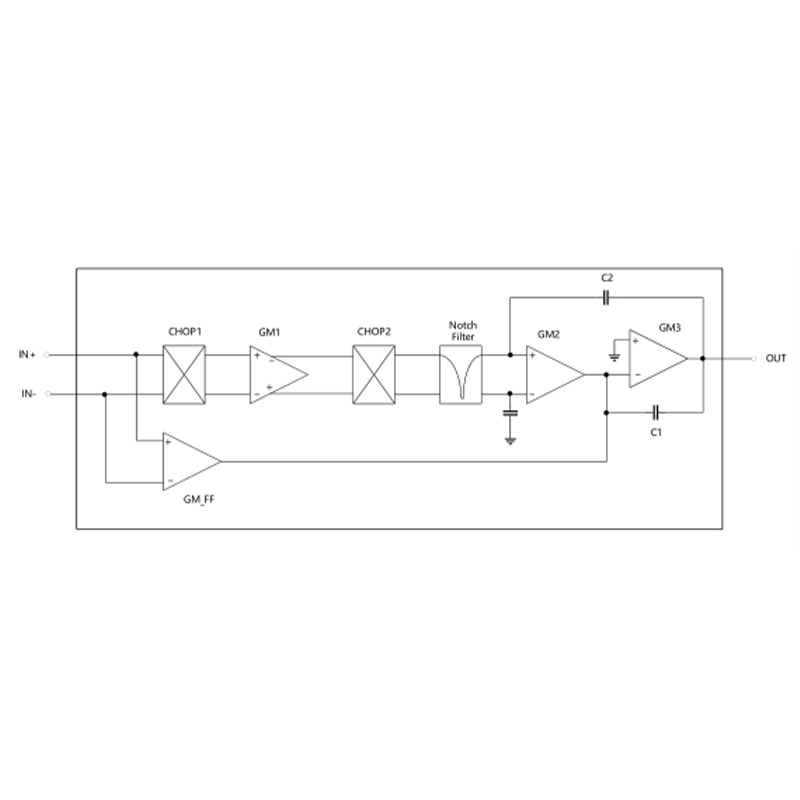

Модуль передачи данных

Модуль передачи данных -

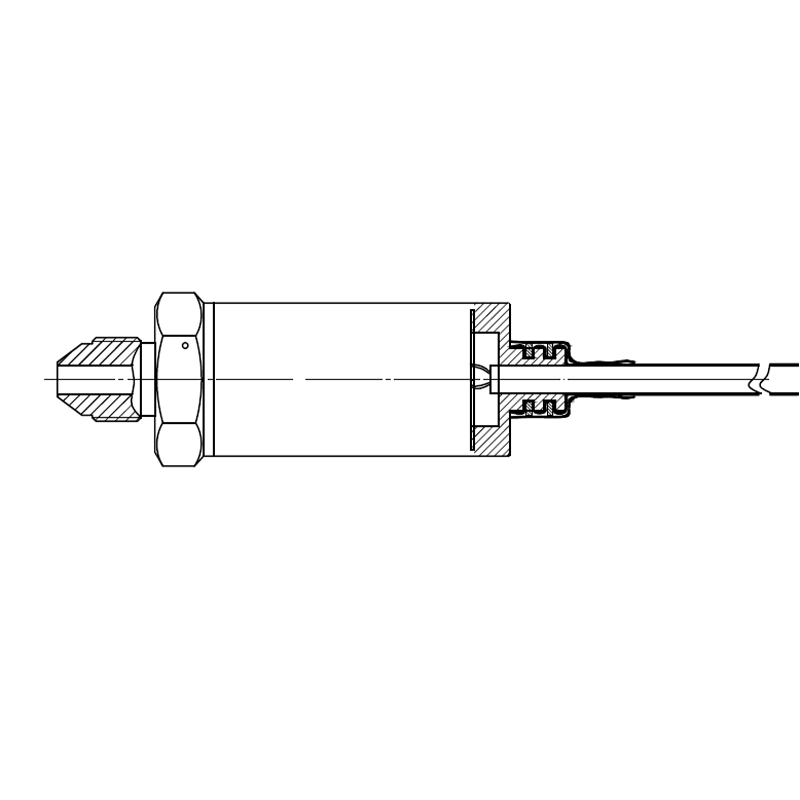

Датчик давления – Тип D

Датчик давления – Тип D -

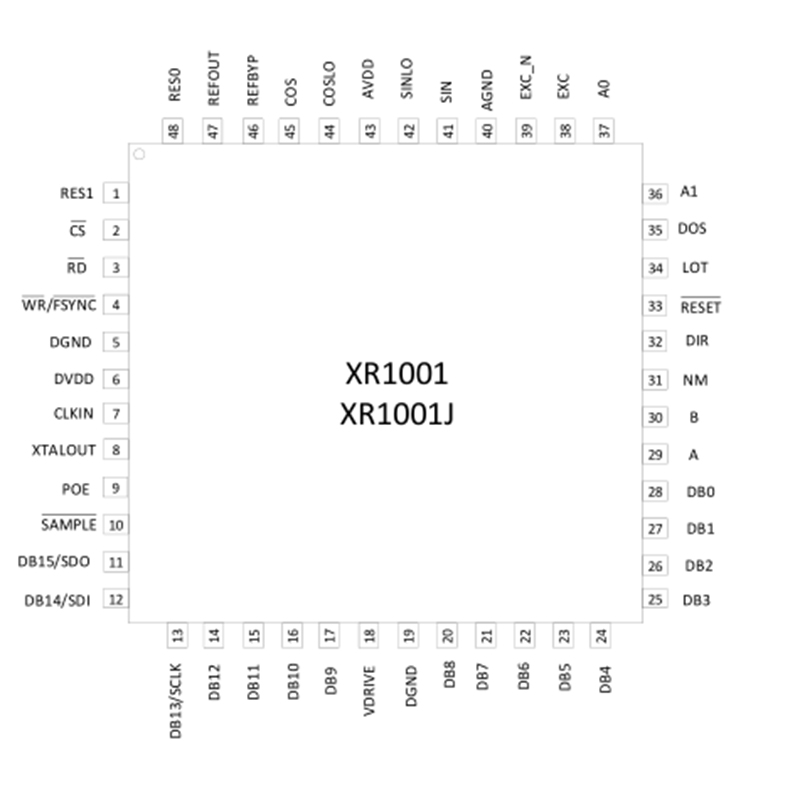

CAXR188/2188/4188

CAXR188/2188/4188 -

Радиочастотный силовой транзистор MRFE6VP100HR5

Радиочастотный силовой транзистор MRFE6VP100HR5 -

RSFK2492F009C1

RSFK2492F009C1

Связанный поиск

Связанный поиск- Трехосный гироскопический модуль чаочжи sigm9030r

- Caxr8314 – детектор/контроллер rf 0.05-4 ггц производитель

- Датчик давления as20h-450 заводы

- Высоконадежный датчик давления производитель

- Анализатор сигналов заводы

- Датчик давления as20h-350 производители

- Высококачественный оптический преобразователь производитель

- Военный силовой транзистор завод

- Специализированный многопараметрический датчик (температура/давление/влажность) производитель

- Комбинированный оптический преобразователь 20-ти канальный производитель